S mladým českým výzkumníkem, který je označován za „zázračné dítě české vědy“, jsme mluvili o strojovém učení, o odhalování deepfake a prevenci „halucinací“, o vzdělávacím potenciálu generativních modelů AI nebo o hranici mezi asistovanou kreativitou a manipulací.

Na Stanfordově univerzitě jste součástí výzkumné skupiny, která se zabývá tím, jak využít různé AI nástroje ve vzdělávacím procesu. V čem vidíte potenciál těchto nástrojů?

Především v personalizované pomoci mimo školu, kde tyto nástroje zprostředkují danou látku formou, která nejvíce odpovídá studijním preferencím daného studenta. Dnes vidíme první vlaštovky v podobě personalizovaných chatbotů, které mohou zodpovídat studentovy otázky a vést jej konkrétními úkoly a problémy. Například online platforma Khan Academy představila chatbota Khanamiga, který při řešení konkrétních úkolů – zatím primárně v přírodovědných a technických oborech – klade návodné otázky, poskytuje rady nebo opravuje a vysvětluje chyby, a to vše živě, zatímco student řeší zadanou úlohu v aplikaci. Stávající podoba tohoto chatbota není nijak úchvatná, ale určitě se bude postupně zlepšovat, jednak díky vývoji AI obecně, jednak na základě interakcí. Stejně jako mnohé další aplikace na bázi AI si i Khanamigo ukládá konverzace, které vedl, aby se z nich mohl učit.

Jaké jsou v této oblasti priority z badatelské, akademické perspektivy a jaké z hlediska aplikovaného výzkumu a konkrétních vzdělávacích institucí?

Jasnou prioritou v oblasti výzkumu systémů na bázi velkých jazykových modelů, což je případ nástrojů jako ChatGPT od OpenAI či Gemini od Googlu, je prevence takzvaných halucinací. Jedná se o případy, kdy AI poskytuje neověřené, spekulativní či fakticky chybné informace a prezentuje je jako absolutní pravdu. Tyto případy jsou způsobené tím, že dnešní jazykové modely neumějí reprezentovat faktičnost. Naopak se snaží maximalizovat koherenci a přesvědčivost svých výstupů. První pokus o řešení tohoto problému spočíval v tom, že by se modely naučily samy říct, kdy si nejsou jisté nebo nemají dostatečné informace. To se však ukazuje jako značně komplikované. Alternativním řešením je přimět model citovat své zdroje, což uživateli následně umožní si dané zdroje ověřit a zjistit, zda se prezentované informace shodují.

Společnosti a startupy v oblasti AI a vzdělávání se teď primárně zaměřují na výzkum a vývoj konkrétních forem, jak své systémy studentům zprostředkovat. Jedna věc je vyvinout funkční AI systém, který se umí zorientovat v učebnici či úkolu, druhá věc je najít způsob, jakým bude komunikovat se studentem, píše-li tužkou na papír. Pokud bude AI nástroj po studentovi chtít, aby mu rozepsal kontext nebo naskenoval své řešení, bude student trávit více času připravováním zadání pro AI než vlastním studiem. Řešení je poměrně jednoduché v případě, že si student píše poznámky na tabletu, kde může být AI pomocník integrován přímo v poznámkové aplikaci. Zkrátka, firmy a startupy experimentují s mnoha způsoby, jak se dostat do studentova „flow“, aniž by to pro něj představovalo zátěž.

V jedné ze svých přednášek jste parafrázoval název eseje kanadského spisovatele Stephena Marche: Studentský esej je mrtvý. Znamená to i něco jiného než kapitulaci před kreativními možnostmi generativních nástrojů AI?

Já si to vykládám jako snahu překonat lpění na eseji jakožto preferované formě studentských výstupů v humanitních předmětech. Nutno podotknout, že toto lpění je v kontextu anglosaských vzdělávacích systémů zcela jiné v porovnání s tím českým. Teď to ostatně sám pociťuji. Myšlenka je však relevantní i v českém prostředí: vzdělávání by mělo reflektovat skutečnost, že napsání koherentního odstavce či syntéza několika pramenů už není ryze lidskou výsadou. To neznamená, že by se studenti neměli učit psát kvalitní a originální texty. Naopak ti, kteří budou schopni vystoupit z průměru, k němuž nástroje jako ChatGPT tíhnou, budou do budoucna nesmírně ceněni. Obdobně to neznamená, že by se studenti neměli učit pracovat se zdroji. Osvojení si těchto dovedností bude pro zachování autenticity v informační sféře ovládané AI naprosto kritické. Ovšem ptal bych se i na to, jak můžeme AI nástroje v momentě, kdy si studenti zmíněné kritické schopnosti osvojí, integrovat do jejich praxe tak, aby po ukončení studia byli schopni se uplatnit ve světě, který bude stále větší množství úkonů automatizovat. Proto si titul eseje nevykládám jako kapitulaci před kreativními možnostmi generativní AI, ale jako výzvu k zamyšlení nad tím, jak dnes vzdělávat studenty způsobem, který se k umělé inteligenci staví kriticky, ale i produktivně – aby ve světě za několik let, na který je tak usilovně připravujeme a o němž toho příliš nevíme, byli schopni se orientovat.

Věnujete se problematice deepfake videí. V souvislosti s literární tvorbou, povídkami a romány generovanými AI se používá termín „asistovaná kreativita“. Lze podle vás určit hranici mezi asistovanou kreativitou, mystifikací a manipulací?

Donedávna jsem si myslel, že hranice asistované kreativity, mystifikace a manipulace lze poměrně jasně vytyčit na základě autorské intence. V poslední době se ale můj názor mnohokrát změnil – jako nedávno, kdy jsem se snažil tyto fenomény reflektovat ve vizuálním umění a poznatky pak aplikovat na literaturu. V tomto ohledu mě zaujala tvorba Trevora Paglena, současného umělce, který ukazuje, že historie AI, mnohdy spojená s vládními projekty bezpečnostních služeb, dala nástrojům umělé inteligence cejch manipulace a mystifikace, což ovlivňuje určité tendence těchto systémů. Paglen se ptá, zda se umělec, který AI nástroje využívá s intencí asistované kreativity, může vyhnout těmto historickým tendencím a vytvořit dílo prosté manipulace a mystifikace.

Jakou odezvu měla spolupráce se CNN, kdy jste s profesorem Hanym Faridem z Kalifornské univerzity v Berkeley vytvořili prvního umělého moderátora televizního zpravodajství?

První odezva přišla ještě před vysíláním od manažerů CNN, kterým naše video někdo pustil bez varování, že se jedná o deepfake, aby se zjistilo, jestli se některý z nich nad ním pozastaví. Nepozastavil. A pravdu se dozvěděli až následně. Z jejich zprávy byl patrný strach, ale také obdiv k technologii. Jinak nám přišla i řada dalších reakcí, jak od veřejnosti, tak z odborné komunity. Přečetl jsem si všechny, od díků přes varování až po výtku, že jsme jakožto výzkumníci v AI součástí problému – přestože v laboratoři pracujeme právě na technologiích pro detekci podobných videí. Byla to velmi bohatá paleta názorů. Takže video zaujalo a vyvolalo produktivní diskusi.

Generativní modely ukazují, že i sama umělá inteligence je schopná se učit. Je možné ji naučit morálním zásadám?

To je předmětem výzkumu řady předních vědců oboru již řadu let – mnohdy se používá pojem „AI alignment“, tedy srovnání zásad a priorit těchto systémů s těmi lidskými. Dosavadní výsledky ale nejsou zdaleka dostatečné. Stále nemůžeme prohlásit, že se dané systémy kýženým morálním zásadám skutečně učí. Další problém představuje samotná formulace a reprezentace těchto morálních zásad. Učebnicovým příkladem jsou samořídící auta: pokud auto ví, že nestihne zastavit, a musí si vybrat mezi třemi možnostmi – například narazit se svou posádkou do stromu, srazit cyklistu, nebo najet na chodník plný kolemjdoucích –, co je morálně nejlepší řešení? Je vůbec etické jednotlivým kategoriím explicitně přidělovat určité hodnoty? Ale na druhé straně: co se stane, pokud tak neučiníme?

Jeden spisovatel před lety napsal, že stroje zvítězí nad člověkem v okamžiku, kdy začnou vyprávět příběhy. Díky ChatGPT už to dokážou. Máme se bát?

Důvodů, proč se bát, lze určitě nalézt mnoho. Mou největší obavou je schopnost těchto systémů manipulovat, a to v bezprecedentním rozsahu, způsoby mnohem sofistikovanějšími, než jak to činí dnešní dezinformace. V tomto ohledu mě nejvíc znepokojují dvě skutečnosti. Zaprvé, že už dnešní dezinformace přes svou jednoduchost zvládnou manipulovat s notnou masou. A zadruhé, že se stávající konvenční dezinformace nedočkaly žádné systémové vládní odpovědi. Obojí by nás mělo pobízet k větší akceschopnosti. Přesto bych ale rád zdůraznil, že tento strach – nebo spíš respekt – by neměl být svazující. Měli bychom využívat skvělých inovací, které AI přináší, ale zároveň se mít na pozoru a preventivně předcházet rizikům.

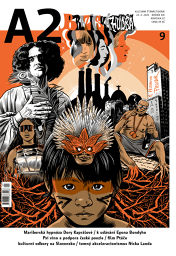

Matyáš Boháček (nar. 2004) v současnosti studuje na Stanfordově univerzitě a působí jako výzkumník v laboratoři profesora Hanyho Farida při Kalifornské univerzitě v Berkeley. Programování se věnuje od šesti let. Vyvinul např. aplikaci na odhalování deepfake obsahu, podílel se na výzkumu rozpoznávání a překladu znakového jazyka pomocí umělé inteligence.