AI alchymie a konec lidstva

K čemu povede experiment s umělou inteligencí?

Kniha Eliezera Yudkowského a Natea Soarese s podtitulem Proč by superinteligentní AI vyhladila lidstvo předkládá řadu argumentů proti nekontrolovanému rozvoji umělé inteligence. Autoři přesvědčivě ukazují, jak moc podceňujeme rizika dalšího technologického pokroku v této oblasti.

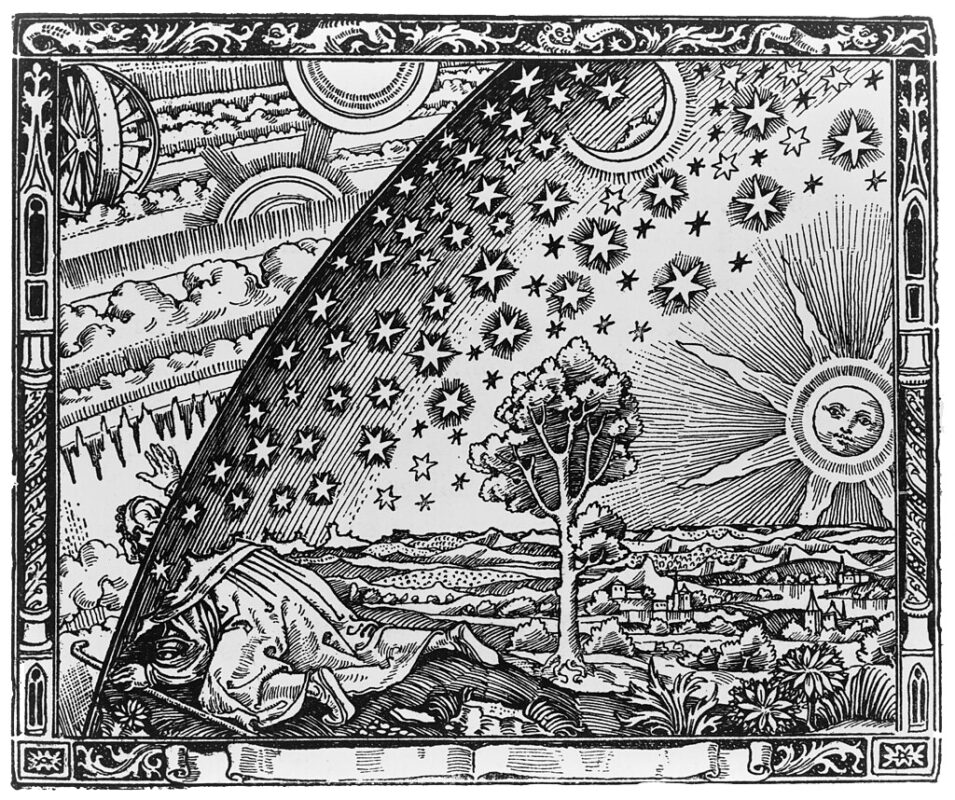

Rytina z knihy Camilla Flammariona L’atmosphère, 1888

„Neříkáme to jako nadsázku, nepřeháníme pro efekt. Pokud jakákoli společnost nebo skupina kdekoli na planetě pomocí čehokoli byť jen vzdáleně podobného současným metodám vyrobí superinteligentní AI založenou na čemkoli byť jen vzdáleně podobném současnému chápání AI, pak všichni, všude na Zemi, zemřou,“ tvrdí američtí výzkumníci Eliezer Yudkowsky a Nate Soares v nové knize If Anyone Builds It, Everyone Dies: Why Superhuman AI Would Kill Us All (Pokud vznikne, všichni zemřeme. Proč by superinteligentní AI vyhladila lidstvo, 2025). Protože sám pracuji v oboru AI, mám k publikaci různé výhrady. Přesto myslím, že se jedná o doposud nejlepší vysvětlení problému umělé inteligence, které navíc nevyžaduje speciální technické znalosti a překvapivě se při četbě i zasmějete. Nejprve je však potřeba vyjasnit několik možných nedorozumění. Tvrzení obsažené v názvu knihy přece jen působí poněkud přehnaně.

Zabránit vyhynutí

Kniha se dělí na tři části, které se postupně zabývají otázkami, proč by vznik superinteligentní AI způsobil konec lidstva, jak by onen konec mohl probíhat a konečně jak to souvisí se současnou situací ve světě a co se s tím dá dělat. Odpověď autorské dvojice zní: „Zastavit vývoj AI a brát ten zákaz smrtelně vážně.“

…